20240319 英伟达发布Blackwell GB200 AI加速卡

🦉 AI新闻

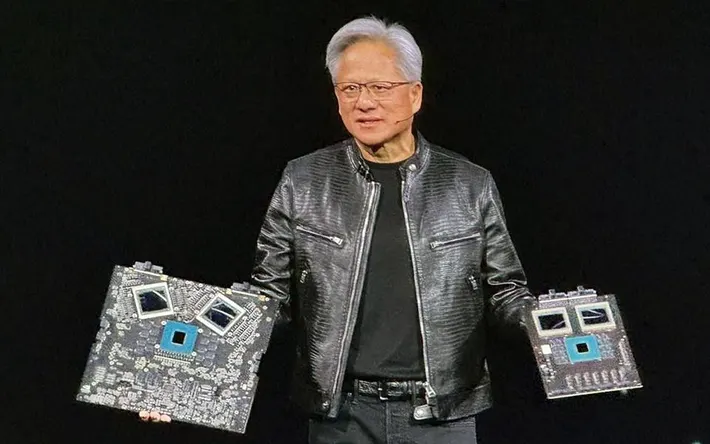

🚀 英伟达发布Blackwell GB200 AI加速卡

摘要:英伟达在GTC开发者大会上发布了最强AI加速卡GB200,它基于新一代AI图形处理器架构Blackwell,预计今年晚些时候发货。GB200性能大幅超越前代Hopper架构的H100加速卡,AI性能达到20 petaflops,是H100的5倍。该加速卡采用台积电4纳米工艺,拥有双芯片设计,通过NVLink 5.0高速连接。GB200还集成了基于Arm的Grace CPU,能显著提升大语言模型的推理性能,将成本和能耗降至原来的25分之一。英伟达还提供了面向大型需求的企业解决方案,包括用于服务器的完整方案和用于更大规模部署的DGX Superpod系统。

🚀 苹果有望集成谷歌Gemini AI至iPhone

摘要:彭博社的报道揭示了苹果公司目前正在与谷歌就在iPhone中集成Gemini人工智能引擎展开谈判,旨在促成一项可能改变AI行业面貌的协议。此外,苹果也在考虑OpenAI的模型,并已积极研究自己的AI大模型,包括发布名为“MM1”的多模态大模型研究论文,并通过收购DarwinAI加强其AI领域的实力。此次合作将可能为苹果iPhone的新功能引入强大的AI支持,显示出苹果在加深其AI技术领域布局的决心。

🚀 OpenAI CTO对Sora训练数据源含糊其词

摘要:近期,OpenAI推出的文本转视频生成模型Sora引发关注,但其CTO Mira Murati未能明确回应Sora的训练数据来源。在接受华尔街日报采访时,面对数据来源的直接提问,Murati只是模糊表示使用了公开可用和许可数据,对于是否包含YouTube、Instagram或Facebook视频以及与Shutterstock的合作关系避而不谈,并强调数据源“肯定是公开可用或经过许可的”。此事引起网络热议,有人质疑Murati对产品的了解,也有人认为公开内容应允许使用。不明确的数据来源让OpenAI面临尴尬境地,增加了公众对AI训练数据透明度的质疑。

🚀 MIT研究:LLM能力增速超摩尔定律

摘要:近日,MIT FutureTech的研究团队发表了关于大型语言模型(LLM)能力增长速度的研究,发现LLM的能力大约每8个月便翻一倍,这一增长速度远超过摩尔定律预测的硬件发展速度。该研究结果表明,随着时间的推移,我们可能无法提供足够的算力来支持LLM的发展需求。这项研究基于200多个语言模型进行了评估,并采用了复杂的模型来量化LLM的能力提升,揭示了AI算力需求增速的惊人现象,同时也对AI的未来提出了思考。

🚀 澜舟科技与李开复合作 推动AI技术发展

摘要:澜舟科技在其2024年技术和产品发布会上宣布,与创新工场李开复旗下的零一万物达成战略合作。李开复表示,目前最优秀的大模型智力是人类平均水平的三倍,使大模型在应用层面上出现“杀手级”应用,用户增长速度显著。零一万物已推出Yi-34B和Yi-6B两款开源大模型,并从学术研究和商用角度支持AI发展。李开复提到,中国AI竞争激烈,但未来将涌现出几家大赢家。

🗼 AI知识

🔥 详解专家混合(MoE)模型

MoE模型是一种在开放AI社区中备受关注的变压器类模型,可以通过专家混合的方式实现高效的预训练和快速的推理。MoE模型由两个主要元素组成:稀疏的MoE层和路由器。在MoE模型中,每个MoE层代替了变压器模型中的FFN层,并由专家和路由器组成。专家是神经网络,路由器决定将哪些标记发送给哪个专家。MoE模型的预训练速度比密集模型快,推理速度也更快,但需要更高的显存。除了优势外,MoE模型也面临挑战,如训练困难和推理速度。MoE模型的发展历程可以追溯到1991年,经历了多个研究领域的探索,最终在NLP领域得到应用。通过稀疏性和条件计算等技术,MoE模型可以实现高效的预训练和推理。MoE模型的发展方向包括Fine-tuning、指导调整和量化等。MoE模型在高吞吐量场景中表现出色,而在低吞吐量场景中,密集模型更具优势。MoE模型的开源项目有Megablocks、Fairseq和OpenMoE等。MoE模型的未来方向包括蒸馏、模型融合和极端量化等领域的探索。

更多AI工具,参考国内chatgpt4me,Github-chatgpt4me